- 22 septiembre 2014

- Cultura Empresarial, Economía, Empresa

Habiendo acumulado más de 45 años de experiencia laboral, tanto como empleado y ejecutivo en muy distintas empresas de todos los tamaños, de origen nacional como internacional y en las más diversas actividades, ya sea de producción como de servicios o de educación, me he dado cuenta que el enfoque de sistemas está totalmente ausente en la mente de los directivos.

Además, desde hace unos 20 años me he dedicado a la enseñanza a nivel universitario y de posgrado en programas de negocios y administración y mejoramiento de organizaciones, notando que los alumnos llegan a los cursos carentes de estos conceptos.

De aquí se puede concluir que el enfoque sistémico ya pasó a mejor vida y que deben existir otros modelos que explican mejor la vida de las organizaciones, pero esto no parece ser así. No es que haya muerto, puesto que nunca ha terminado de nacer. No se ha sembrado, ni cultivado, y por lo tanto está totalmente ausente de la mente de los líderes organizacionales y los demás niveles de las organizaciones. El cultivo está pendiente de hacerse.

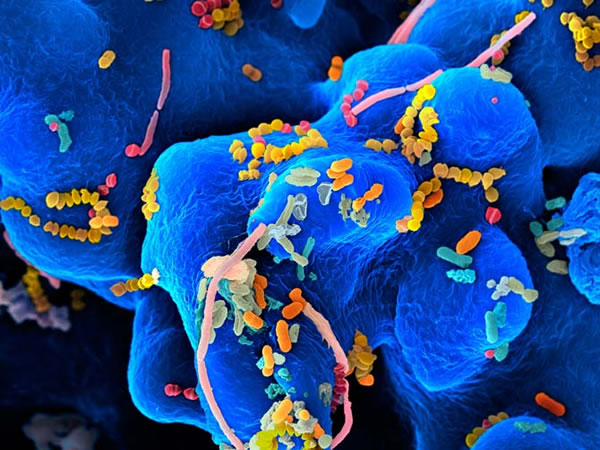

“¿Y …?”, se puede preguntar el lector, así como responderse que el mundo ha seguido como si nada, principalmente el de las organizaciones, sin necesidad de estos conceptos. Ahora bien, esto no es así de intrascendente, ya que se ha dejado en un segundo plano la conciencia de que las organizaciones son organismos sociales vivos. Como tales, reciben del medio ambiente una serie de elementos que los nutren y les permiten hacer lo que tienen que hacer, y a su vez, deben entregar una serie de productos y servicios, según lo requerido.

Cuando está ausente la idea de que las organizaciones son sistemas vivos y que están abiertos al intercambio con su entorno, los líderes suelen errar el diseño de las estrategiasy retrasar su avance, o más aún, llevarlas al fracaso. En estas épocas es notoria la influencia de la globalización, de la apertura de las comunicaciones y de su inmediatez; sin embargo, los directivos en muchos casos actúan como si no hubiera más mundo que el que alcanzan con la vista.

Ahora el entorno externo a las organizaciones, sobre el cual no se puede tener control, pide y a veces exige para poder interactuar, condiciones y características que hace 20 años no interesaban. Se hace énfasis en la importancia de actuar con Responsabilidad Social,ser sustentable, comprar y vender a precios justos, en fin, proyectar hacia afuera de la organización una vida organizacional ética.

Al existir una poderosa fuerza de globalización en las comunicaciones, resulta que ahora la actuación de las organizaciones se conoce en todo el mundo. Lo malo y negativo vuela y corre mucho más rápido entre los consumidores y la opinión pública que las buenas actuaciones y el buen servicio. La imagen del buen servicio y la buena calidad se trasmite de boca en boca, con un efecto bastante duradero.

Pero ¿a qué se refiere la “Teoría General de Sistemas”? Pues quiere decir que la única manera significativa de ver a las organizaciones es como un sistema social. Estos conceptos no son nuevos, están cerca de cumplir un siglo, pero no han terminado de sembrarse en el mundo de las organizaciones.

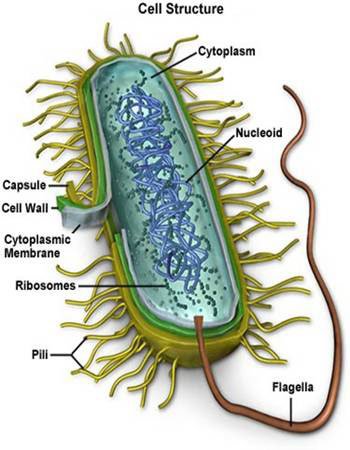

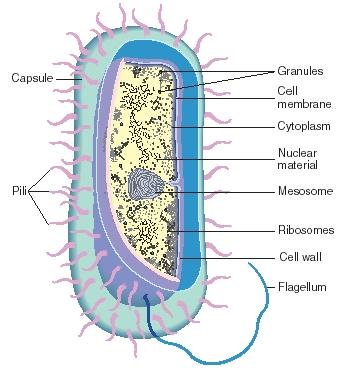

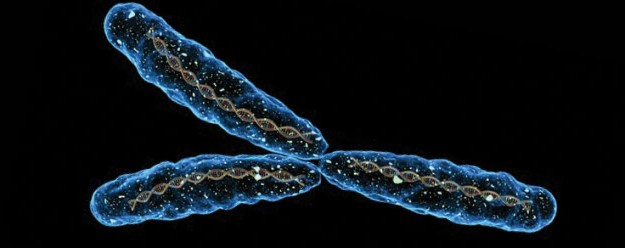

Si hay que ir a las definiciones, vale la pena tomar la que dice que un sistema viene a ser“untodo unitario organizado, compuesto por dos o más partes, componentes o subsistemas interdependientes y delineado por límites identificables por su suprasistema ambiente” (Kast & Rosenzweig, 1988).

De ella vale la pena enfatizar, por ahora, que las organizaciones, vistas desde el enfoque sistémico son interdependientes de su suprasistema ambiental. Este ambiente externo no solo se referirá a los competidores, proveedores, factores macroeconómicos, mundiales y nacionales, sino a los ecológicos y los del ambiente climático.

Lo que se hace o deja de hacer en una organización no solo repercute dentro de ella, sino en otras organizaciones que están en su entorno cercano y lejano. Es como cuando se tira una piedra en un estanque, va produciendo olas que se alejan de su centro. Lo que se hace afecta a otros, y lo que los demás hacen o deciden, invariablemente nos afecta.

En estos párrafos se ha querido hacer ver que la mayoría de los líderes están ayunos de los conceptos administrativos que les permitan conducir hacia el mejoramiento a sus organizaciones, sin importar si éstas son de negocios o no lucrativas. Se ha querido enfatizar que la “Teoría General de Sistemas” constituye un enfoque global desde el que se puede entender todo tipo de sistemas, entre ellos los organizacionales.

Referencias

Kast, F., & Rosenzweig, J. (1988). Administración en las oranizaciones. Enfoque de sistemas y contingencias (2a ed.). (M. A. Malfavón, Trad.) México: McGraw Hill.

Fernando Menéndez González

Universidad Iberoamericana (UIA)